Genbearbeitung & Künstliche Intelligenz: Large Language Models als generative KI-Tools im Einsatz

Folgender Beitrag basiert auf einem Artikel, der auf Nature.com erschienen ist und im Kern die Thematik der Genbearbeitung mithilfe von Künstlicher Intelligenz und im Rahmen dessen den Einsatz von Large Language Models (LLMs) skizziert. Im Zentrum der Forschung stehen die sogenannten CRISPR-Gen-Editierungssystemen, die ich an dieser Stelle nicht genauer erläutern möchte, da ich kein Experte auf diesem Gebiet bin und auch nicht vorhabe, dies in Kürze anzustreben. Im Wesentlichen geht es um haufenweise Daten, die ganz egal in welchen Bereichen der Wissenschaften mithilfe von KI möglichst zügig bearbeitet werden könnten, ob nun in der Biologie, Chemie oder in den Ingenieurwissenschaften oder der Mathematik. Da gäbe es etliche sinnvolle Einsatzmöglichkeiten.

Generative KI als Unterstützer für Forschende

Seit der Einführung des Chatbots ChatGPT, der auf dem Large Language Model GPT basiert, bieten sich spätestens seit der Multimodalität, also der Möglichkeit Dateien hochzuladen, für Forschende plötzlich ganz andere Möglichkeiten, ihre Arbeit zeiteffizient auszuführen. Es gibt unglaublich viele Datensätze, die nur darauf warten auf diverse Kennziffern hin analysiert zu werden. Die Nutzung eines Algorithmus in Form eines Large Language Models wie dem geschlossenen GPT (OpenAI) oder dem offenen Llama (Meta) könnte bei korrekter Handhabung eine (sehr) große Zeitersparnis bedeuten und hätte das Potenzial generell die Forschungsprozesse wie im Rahmen von “CRISPR” stark beschleunigen. Nicht ausschließlich Forscher entwerfen fortan die neuen Systeme, sondern (auch) Language Models unter Aufsicht der Forschenden.

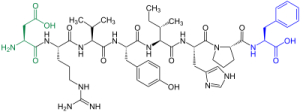

Während Chatbots wie ChatGPT darauf ausgelegt sind, Sprache zu verarbeiten, nachdem sie anhand vorhandener Texte trainiert wurden, wurden die CRISPR-entwerfenden KIs stattdessen anhand riesiger Bestände biologischer Daten in Form von Protein- oder Genomsequenzen trainiert. Quelle: Nature.com

Biologische Datensätze als Trainigsgrundlage

Die Forschenden im Beitrag von Nature.com nutzen dabei die Multimodalität des LLMs bzw. die Upload-Funktion, um darüber unzählige Datensätze in Form von Protein- oder Genomsequenzen hochzuladen und das Sprachmodell genau auf diesen “kleinen” Themenbereich zu spezialisieren. Unter anderem das Biotechnologieunternehmen Profluent mit Sitz in Berkeley (Kalifornien) rund um den Geschäftsführer Ali Madani arbeitet an dieser Methodik. Auf der Grundlage des LLM-Trainings konnten so nun weitere (neue) Datensätze mithilfe der Künstlichen Intelligenz und ohne mühsames Forschen von Menschen generiert werden, also ganz fix per Knopfdruck und wohl insgesamt auch kostensparender.

„Das ist erstaunlich“, sagt Noelia Ferruz Capapey, Computerbiologin am Institut für Molekularbiologie in Barcelona in Spanien. Sie ist beeindruckt von der Tatsache, dass Forscher das OpenCRISPR-1-Molekül im Gegensatz zu einigen patentierten Gen-Editing-Tools ohne Einschränkungen verwenden können. Das ProGen2-Modell und der „Atlas“ der CRISPR-Sequenzen, die zur Feinabstimmung verwendet werden, sind ebenfalls frei verfügbar. Quelle: Nature.com

Fazit

Besteht die Möglichkeit, Künstliche Intelligenz etwa in Form von generativen Algorithmen wie Large Language Models (Llama, GPT & Co) gezielt zur Unterstützung von Forschung innerhalb der weiten Welten der Wissenschaften einzusetzen, um z.B. schwere Erkrankungen zu heilen oder besser zu therapieren, dann ist dies eine mehr als sinnvolle Alternative zur klassischen Forschung auf Grundlage des menschlichen Geschicks. Natürlich müssen alle Beteiligten verstehen, welche Risiken und Macken solche Sprachmodelle mit sich bringen. Alles der KI überlassen und per Copy & Paste dann die Outputs “nur” einfügen, ist mit Sicherheit nicht der richtige Weg. Vertrauen ist gut, aber Kontrolle definitiv besser, ganz egal wie gut die LLMs in Zukunft auch noch werden sollten.

Ja, dieser spezielle Anwendungsfall im Bereich der Genbearbeitung in Kombination mit KI ist wohl besonders sensibel, aber diese Entwicklung lässt sich ganz bestimmt nicht aufhalten, auch wenn Deutschland und ganz Europa diese Verfahrensweisen verbieten sollten. Dann wird halt woanders geforscht. Frei verwendbare Modelle wie Llama 3 sind mehr als sympathisch, da sie komplett offen sind und so Forscher auch neue Gen-Editing-Tools über Plattformen wie GitHub teilen könnten, wodurch die Forschung weltweit insgesamt an Dynamik gewinnen könnte. Schlecht wäre eine Konzentration solcher Anwendung auf wenige Firmen mit Patentierungen und hohen Lizenzkosten. Open-Source-Sprachmodelle hätten das Potenzial, diese “Machtstrukturen” aufzubrechen, damit jeder Forschende mit Top-Editing-Tools arbeiten darf und zwar dauerhaft kostenfrei.

Empfohlene Publikation

Ruffolo, J. A. et al. Preprint at bioRxiv https://doi.org/10.1101/2024.04.22.590591 (2024).