Gerechtere Notengebung durch den Einsatz von Künstlicher Intelligenz? Eine IU-Studie lässt aufhorchen!

Eine Klausur mithilfe von künstlicher Intelligenz via Tool-Upload bewerten lassen und dadurch nicht nur Zeit sparen, sondern auch noch die Fairness bei der Notenverteilung über eine maximale Objektivität gewährleisten. Diese Fragestellung steht im Mittelpunkt einer Studie der IU Internationale Hochschule.

- Ein Forschungsteam der IU hat ein neuartiges KI-Modell trainiert, indem es eine große Anzahl von Prüfungsdatensätzen aus verschiedenen Fächern der IU verwendet hat.

- Die mehrstufige Analyse der Daten zeigt, dass KI-gestützte Benotung in der Lage ist, menschliche Subjektivität und Ungenauigkeit zu reduzieren.

- Das Forschungsteam empfiehlt aus rechtlichen und akademischen Gründen, die KI zunächst nur zur Unterstützung des menschlichen Urteilsvermögens einzusetzen.

- Das KI-Modell ist in vielen Disziplinen anwendbar und anpassungsfähig.

Die angeführten Punkte sind eine Zusammenfassung der IU-Studie, in deren Mittelpunkt Prüfungsdatensätze aus einem breiten Spektrum an Fächern stehen, also von den Geisteswissenschaften bis hin zu den MINT-Themenfeldern.

Automatic Short Answer Grading (ASAG) System

Zur automatisierten Bewertung über eine Künstliche Intelligenz wurde ein ganz eigenes Bewertungssystem mit der Bezeichnung Automatic Short Answer Grading (ASAG) System eingeführt.

Das IU-Forschungsteam hat dafür ein neuartiges Bewertungssystem entwickelt, das sogenannte Automatic Short Answer Grading (ASAG) System, das Antworten auf offene Fragen, die aus wenigen Sätzen bestehen, automatisch bewerten kann.

Das ASAG-System der IU Hochschule basiert dabei auf einem großen Sprachmodell, einem sogenannten Large Language Model (LLM), wie z.B. GPT-4 von OpenAI. Für einen bestmöglichen Output wurde das LLM mit großen Prüfungsdatensätzen von vergangenen Klausuren der IU-Studierenden mittels Upload “gefüttert” und so trainiert.

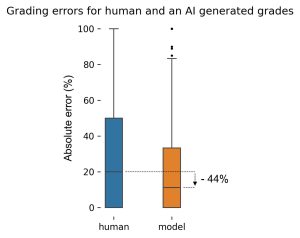

KI-Modell genauer bei Klausurbewertung als menschliche Prüfer

Die folgende Abbildung der IU-Studie zeigt als Resultat, dass eine vorab trainierte Künstliche Intelligenz in Form eines großen Sprachmodells näher an der Referenznote liegt als menschliche Prüfer. Oder anders formuliert,: Eine KI macht weniger Fehler, da sie theoretisch zu 100 % objektiv analysiert, fernab von Emotionen/Sympathien oder “einem schlechten Tag”, also dem Verursachen von Unregelmäßigkeiten.

Fazit: Mehr Effizienz & Fairness durch Künstliche Intelligenz. Aber Frage der Rechtslage offen?

„Die Einbindung von KI-gestützten Modellen in die Benotungsprozesse bietet erhebliche Vorteile: Zum einen erhalten Prüfer:innen dadurch einen externen Maßstab zum Abgleich ihrer eigenen Bewertung. Dies führt zu verminderter Varianz und somit erhöhter Fairness der Bewertung, was den Studierenden zugutekommt. Zum anderen entlastet es Professor:innen und Tutor:innen von langwierigen und sich wiederholenden Aufgaben, sodass sie sich stärker auf die Lehre und Betreuung der Studierenden konzentrieren können“, sagt Prof. Dr. Thomas Zöller, Professor für Data Science und Artificial Intelligence an der IU Internationalen Hochschule.

Wie Prof. Dr. Thomas Zöller im oberen Zitat argumentiert, ist die Kombination aus mehr Fairness/Transparenz und potenzieller Zeitersparnis seitens der Lehrenden schon sehr stark! Auch würde eine “KI als Überprüfer” den Druck auf die Prüfer senken, da etwa einfache Fehler mit möglichen Verwirrungen als Folge konsequent vermieden werden können. Stehen Prüfer wie Professorinnen und Professoren weniger unter Druck, dann können sie aus meiner Sicht auch besser arbeiten und den Fokus mehr auf das Feedback legen. Sehr einfache Fehler entstehen schließlich nicht selten im Rahmen von sehr stressigen und monotonen Arbeitsprozessen. Eine Künstliche Intelligenz im Rahmen eines LLMs wie GPT würde an dieser Stelle für mehr Entspannung/Entlastung sorgen.

Zusätzlich können Noten nicht mehr so stark von den eigentlichen Leistungen abweichen, wodurch der Korridor nach oben und unten schmaler wird, auch hinsichtlich potenzieller Bevorzugung von ausgewählten Studierenden. Insgesamt gesehen hätte der konsequente Einsatz von KI in der Notengebung viele Vorteile hinsichtlich einer gerechteren Bewertung, aber wie sieht es eigentlich mit dem Datenschutz aus? Dürfen Hochschulen/Lehrende einfach so ohne Zustimmung Klausuren von Studierenden hochladen, die dann wie im Falle von ChatGPT-4 in San Francisco auf den Servern von OpenAI verarbeitet werden? Schwierig zu beurteilen, aber die private IU Hochschule geht da schon mal offensiv voran. Super! Wir können nicht stetig auf 100 % Rechtssicherheit warten, denn die wird es wohl gerade bei uns in Deutschland insbesondere in Zusammenhang mit Künstlicher Intelligenz in der Hochschullehre und auch im Schulunterricht so gut wie nie geben! Also die Mutigen voran? 😉