KI-Avatare mit mehr Emotionen: Synthesia präsentiert “Expressive Avatars” mit realistischerer Stimmlage und Körpersprache

Die britische Firma Synthesia hat mit den Expressive Avatars eine neue Generation von Avataren auf der Grundlage von Künstlicher Intelligenz veröffentlicht, die nun realistischere Stimmlage, Körpersprache und Emotionen wiedergeben sollen. Offiziell werden diese als “EXPRESS-1 model” bezeichnet. Avatare können nun die Stimmung, etwa glücklich oder traurig, besser ausdrücken, passen sich also dem Text an und sprechen diesen nicht einfach mit einer Stimmlage monoton bis zum Ende durch.

Kostenlose Demo zum Testen nutzen

Für alle User stellt Synthesia zu den “Expressive Avatars” eine kurze Demo zur Verfügung, in der ein kurzer Text eingegeben wird und schon lässt sich ein Video mit lippensynchronem Avatar generieren. Dazu fix Name und E-Mail angeben und der Vorgang startet. Nach wenigen Minuten erhaltet Ihr eine Mitteilung per Mail, dass Euer Video fertig ist. Nun den Link in der Mail anklicken und dann werdet Ihr automatisch zu Eurem KI-Avatar weitergeleitet und könnt diese auch weiterverwenden.

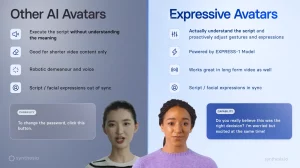

Unterschiede zu “herkömmlichen” Avataren

Synthesia hat auch eine schicke Abbildung zu den Vorzügen der neuen Avatare der EXPRESSIVE-1 models präsentiert. Der ganz wesentliche und wohl auch wichtigste Unterschied ist die “proaktive” Umsetzung des im Vorfeld eingegebenen Skripts etwa in Textform. Auf Grundlage von Text werden nun die potenziellen Emotionen angepasst. Liest sich das Skript etwa lustig mit “funny words”, dann wird der AI Avatar während des gesamten Videos (MP4) folgerichtig auch Gestik, Mimik und natürlich den Tonfall durchweg positiv halten. Hier wird direkt die Stimmung aus dem Text “herausgelesen” und dann gezielt umgewandelt. Das ist neu!

Also falls z.B. im Textskript die Stimmung vom Positiven ins Negative kippt, dann tut dies sichtlich auch die Künstliche Intelligenz. Dies war vorher in den von mir getesteten Tools so nicht möglich. Bislang war es möglich, eine Stimmlage komplett durch das ganze Vide auszugeben und keine abrupten Änderungen etwa in der Stimmlage oder sogar mit Tränen in den Augen, falls jemand sehr gerührt ist. Auch Microsoft hatte mit seinem VASA-1 Modell schon eindrucksvolle Ergebnisse gezeigt.

Im unteren Video erklärt der CTO von Synthesia Jonothan Starck, also der Verantwortliche für die technische Umsetzung der KIs, wie man diese im Rahmen von menschlicher Präsentationen in Zusammenarbeit mit Künstlicher Intelligenz umgesetzt hat.

Fazit

Schlussendlich ist zu sagen, dass Avatare in ihrem Verhalten immer menschenähnlicher werden und wir diese wohl bald kaum mehr voneinander unterscheiden können. Die ist aktuell schon recht schwierig und die Entwicklung in diesem Bereich ist wie in anderen KI-Feldern mehr als rasant. Next? Weitere Top-Tools sind neben Synthesia aus Großbritannien auch HeyGen aus den USA und D-ID aus Israel.