Llama 3 am Start: Open-Source-Sprachmodell auf Spitzenniveau!

Meta AI hat nun die 3. Version des offenen Sprachmodells Llama veröffentlicht. Dazu zählen aktuell die zwei Large Language Models Llama 8B und Llama 70B, deren Bezeichnungen sich nach der Größe richten. Llama 7B kommt auf 7 Milliarden (englisch: Billion = B) und Llama 70B auf 70 Milliarden Parameter. Zudem sind aktuell noch weitere Modelle der “Llama-3-Reihe” mit bis zu 400 Milliarden Parametern im Training und werden in den nächsten Monaten veröffentlicht.

Llama 3 wurde auf über 15 Billionen Token vortrainiert, die aus öffentlich zugänglichen Quellen stammen. Der Datensatz ist siebenmal größer als bei Llama 2, enthält viermal mehr Code und deckt über 30 Sprachen ab. Qielle: The Decoder

Anhand der Entwicklung der Llama-Modelle ist klar zu erkennen, wie stark aktuell das Wachstum bei der Größe der LLMs ist und es scheint weiter anzuhalten, auch bei Open-Source-LLMs wie Llama. Übrigens ist Meta einer der größten Kunden überhaupt von den für das KI-Training so entscheidenden KI-Chips der US-Firma NVIDIA, den sogenannten GPUs, also Grafikprozessoren.

Wo kann ich Llama 3 herunterladen? Unter anderem hier:

1) Auf Meta.ai

https://llama.meta.com/llama-downloads

2) Über HuggingFace

3) Via GitHub

https://github.com/meta-llama/llama3

Es gibt auch noch weitere Plattformen, die Llama 3 und die Vorgänger ihren Kunden anbieten, aber die möchte ich an dieser Stelle nicht alle aufzählen 😉

Empfohlener Beitrag

Beitrag der “Digitalen Profis” zur Nutzung von “Offline-Chatbots” mit Open-Source-Modellen

Testen von Llama 3 über Meta.ai in Europa nur über VPN möglich

Ihr möchtet Llama 3 ganz offiziell über die Webseite https://www.meta.ai testen, dann ist dies für uns deutsche und allgemein europäische User so noch nicht vorgesehen, während in den USA etwa fleißig schon herumprobiert wird und so Erfahrungswerte gesammelt werden können. Versucht Ihr trotzdem Eurer Glück über die offizielle Homepage von Meta, dann taucht der folgende Hinweis Meta AI ist in deinem Land noch nicht verfügbar auf und geht auch nicht mehr weg. Wirklich nicht!

Aber es geht auch anders. Und nein, dies ist kein klassischer Rechtsbruch und es gibt auch keinen Bußgeldbescheid vom Ordnungsamt für dieses Vorgehen. Um doch als deutscher Nutzer Llama 3 über meta.ai testen zu können, verwendet einfach ein VPN, auch gerne als kostenlose Browser-Erweiterung und gebt dort als Standort USA ein. Es gibt auch Tools, die ausschließlich als Location USA anbieten. Ein Wechsel des Standorts nach Europa z.B. in die Niederlande macht einfach keinen Sinn, da Ihr von dort aus auch keinen Zugriff habt.

Eure Browseranfrage läuft also nicht mehr direkt von Deutschland in die USA und wird dort per IP-Erkennung als Location Deutschland erkannt, sondern Eure Browseranfrage läuft zuerst auf einen VPN-Server in den USA und wird dann von dort aus an den Meta-Server in den USA weitergeleitet, wo schlussendlich die Domain liegt bzw. dort offiziell registriert ist. Und zack, schon habt ihr Access und könnt maximal testen.

Im unteren Beispiel wurde mein Standort etwa in Chicago realisiert und dann an Meta weitergeleitet. Deaktiviere ich mit nur einem Klick die Browser-Erweiterung dann wird automatisch wieder wie in meinem Fall Braunschweig angegeben. Über meine einzigartige IP-Adresse werde ich so erkannt. Aber dies muss ja nicht sein.

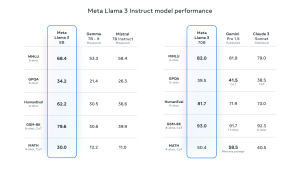

Benchmarks, aber bitte mit Vorsicht!

Und selbstverständlich gibt es zu jedem neuen veröffentlichten Large Language Model (LLM) wie Llama 3 auch die passenden Werte in Form der sogenannten Benchmarks. Wie gut ist denn nun mein LLM und wie steht es im Vergleich zur Konkurrenz dar? Dies steckt schlussendlich hinter der Erhebung von diversen Werten zur Leistungsfähigkeit der Sprachmodelle. Wichtig: Die angeführten Werte sind aus eigenen Messungen der Firmen entstanden. D.h. Meta hat nun selber im eigenen Umfeld getestet wie gut das eigene LLM Lama 3 denn nun sei und diese Werte dann de facto selbstständig (ohne Prüfer) “eingetragen”. Hier müssen User eben Vertrauen haben, ganz egal ob nun in geschlossenen Modellen wie GPT-4 von OpenAI oder offenen LLMs wie Llama 3 von Meta. Wir erinnern uns, auch Automobilkonzerne testen gerne etwa die Abgaswerte der eigenen Motoren (Verbrenner) und geben dazu offizielle Daten raus.

Um maximale Sicherheit im Umgang mit Llama 3 zu gewährleisten, gibt es dann auch noch die passenden Security-Tools wie den Llama-Guard, ein LLM-basiertes Input-Output-Schutzmodell, das auf Anwendungsfälle für Mensch-KI-Konversationen ausgerichtet ist.

Um Llama 3 sicher und verantwortungsvoll einsetzen zu können, stellt Meta verschiedene neue Tools bereit, darunter aktualisierte Versionen von Llama Guard und Cybersec Eval sowie das neue Code Shield, das als Leitplanke für die Ausgabe unsicheren Codes durch Sprachmodelle dient. Quelle: The Decoder