GPT im Handytarif-Stil: Ein datenschutzkonformes und kosteneffizientes KI-Modell für die Hochschulbildung

Ein Beitrag von Professor Uwe Stoklossa

Die Einführung künstlicher Intelligenz in die Hochschulbildung konfrontiert viele Institutionen mit Herausforderungen, besonders in Bezug auf Datenschutz und Kostenmanagement. Die Hochschule Fresenius hat in Kooperation mit scieneers und Microsoft das Projekt “NextGeneration:AI” entwickelt, welches innovative Lösungsansätze für diese Herausforderungen bietet. Das Projekt zeichnet sich durch seine technologische Innovation sowie die Abstimmung auf die Anforderungen der modernen Bildungslandschaft aus.

KI – aber wie?

Die Veröffentlichung von ChatGPT im November 2022 entfachte an vielen Hochschulen die Diskussion um den Einsatz von KI in der Lehre auf einer neuen Ebene. So auch bei uns an der Hochschule Fresenius. Diese Diskussionen führten zu einer ersten Grundsatzentscheidung und der Einführung einer „Handreichung zur Verwendung künstlicher Intelligenzsysteme im Prüfungswesen“. Mit diesem Papier wurden in der Hochschule Fresenius die Türen für eine Anwendung von KI in Forschung und Lehre geöffnet und der Einsatz auch von der Leitungsebene offiziell befürwortet..

Damit war aber auch klar, dass auf breiter Ebene ein niederschwelliger Zugang zu einem KI-Chatbot ermöglicht werden musste. Und zwar nicht nur für die festangestellten Lehrenden, sondern auch für alle Studierenden und auch für die Mitarbeiter:innen aus der Verwaltung, sowie externe Dozierende, die für die Hochschule unterrichten. Denn wenn in Prüfungen KI eingesetzt werden darf, dann muss auch für alle Chancengleichheit herrschen.

Problem Datenschutz

Fast alle identifizierten Einsatzmöglichkeiten für KI-Chatbots in der Hochschule betrafen unternehmensinterne oder personenbezogene Daten. So war schnell klar, dass selbst ChatGPT Plus Accounts diese Anforderungen nicht erfüllen konnten. Ein DSGVO konformes Modell konnte nur in Eigenregie auf die Beine gestellt werden. Der Durchbruch kam durch den Vorschlag der Firma scieneers in Kooperation mit Microsoft, als sie die Option vorstellten, die Sprachmodelle von OpenAI über API auf der Microsoft Azure Cloud zu implementieren. Hier garantiert Microsoft umfangreiche datenschutzrechtliche Voraussetzungen. Nähere Informationen finden sich hier. Die Tatsache, dass wir in der Unternehmensgruppe Carl Remigius Fresenius Education Group ohnehin mit Microsoft Accounts arbeiten und die Azure Cloud bereits im Einsatz haben, hat diese Entscheidung deutlich vereinfacht. Und auch unsere Datenschutzabteilung hat nach umfangreichen Prüfungen unserem finalen Produkt das erhoffte grüne Licht gegeben.

Problem Kostenkontrolle

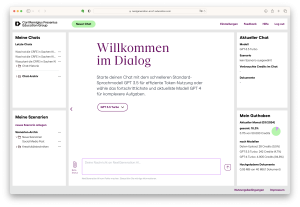

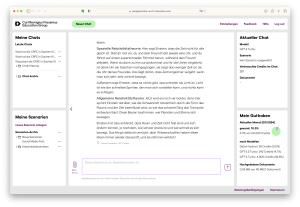

Wir hatten also eine Möglichkeit gefunden, für alle Nutzer:innen einen Chatbot zu entwickeln, der auf die Sprachmodelle GPT3.5 Turbo und GPT4 Turbo zurückgreift und datenschutzkonform arbeitet. Nun fallen dabei aber auf mehreren Ebenen Kosten an. Zum einen für die Nutzung der Azure-Services, zum anderen Lizenzkosten für die Nutzung der Sprachmodelle von OpenAI. Diese Kosten stellten bei einer offenen Nutzung für rund 36.000 Nutzer:innen zu Projektstart ein unkalkulierbares Risiko dar. Zumal es keinerlei Erfahrungswerte gab, wie viele Personen das Angebot überhaupt nutzen und wie intensiv es dann von denjenigen jeweils genutzt wird.. Unsere Hochrechnungen zeigten in manchen Szenarien durchaus besorgniserregende Größenordnungen. Und natürlich kann man einem Vorstand auch keine nach oben offene Kalkulation für ein IT-Projekt vorlegen und eine Zustimmung erwarten. Wir brauchten also ein Konzept, wie das Kostenrisiko kalkulierbar und steuerbar gemacht werden konnte. Hier kam die Idee, sich an den Datenvolumen-Optionen der Handy-Verträge zu orientieren. Alle Nutzer:innen bekommen ein festes monatliches Budget, für das sie das Tool nutzen können. Wenn das Budget aufgebraucht ist, können sie auch erst im nächsten Monat wieder chatten. Zusammen mit den Projektpartnern konnte eine technische Lösung gefunden werden, wie eine solche Kostenkontrolle implementiert werden konnte.

Im Detail gab es hier dann noch einiges zu beachten. Der Verbrauch wird durch OpenAI in „Tokens“ gerechnet. Diese Tokens kosten allerdings je nach Sprachmodell unterschiedlich viel Geld. Um für unsere Nutzer:innen möglichst viel Flexibilität und Transparenz zu schaffen, haben wir unsere eigene Währung, die „Credits“ entwickelt. Die Tokens der unterschiedlichen Sprachmodelle werden in unsere Credits umgerechnet und so kann man in der Nutzung unkompliziert sehen, was bestimmte Abfragen in den jeweiligen Sprachmodellen an Credits kosten und dass die eben bei GPT4 Turbo deutlich höher liegen als bei GPT3.5 Turbo. Das ist auch der Grund, warum wir beide Sprachmodelle zur Auswahl anbieten. Die Nutzer können für jeden Chat entscheiden, welches Sprachmodell in diesem Chat zum Einsatz kommen soll. Je nach Einsatzzweck reicht eventuell GPT3.5 und es werden damit auch noch Credits gespart, oder die Anforderung benötigt GPT4 zur befriedigenden Generierung einer Antwort, dann kann das ebenso bewusst vorher ausgewählt werden, weil der Output den höheren Verbrauch an Credits dann auch wert ist.

Natürlich ist das System so angelegt, dass die Zuweisung und Höhe der Credit-Volumen jederzeit anpassbar ist. So können wir die Nutzungsintensität steuern und perspektivisch auch einzelnen Personengruppen individuell höhere Monatsguthaben zuweisen, wenn zum Beispiel an konkreten Projekten gearbeitet wird, oder wenn bestimmte Abteilungen in der Verwaltung wie z.B. das Marketing, oder die Content-produktion deutlich höhere Datenvolumen benötigt für einen effizienten Einsatz.

Sprachmodelle

Im Bezug auf die LLMs ist wichtig zu erwähnen, dass unsere Plattform „NextGeneration:AI“ von Anfang an so geplant wurde, dass wir nicht ausschließlich an die Nutzung der Sprachmodelle von OpenAI gebunden sind. Es können jederzeit weitere Sprachmodelle angeschlossen werden, solange die sich datenschutzkonform über API anbinden lassen. So könnten europäische Sprachmodelle ebenso integriert werden, wie spezifisch auf wissenschaftliches Arbeiten trainierte Sprachmodelle. Und die Nutzer:innen können dann weiterhin bei jedem neuen Chat entscheiden, welches Sprachmodelle für diesen konkreten Einsatz die beste Wahl darstellt.

Zusätzliche Funktionen

Der große Vorteil bei einer Eigenentwicklung sind ja die Freiheiten die sich dadurch ergeben. So konnten wir nicht nur die Benutzeroberfläche der Plattform vollkommen nach unseren Wünschen gestalten, sondern „NextGeneration:AI“ neben der grundlegenden Chat-Funktionalität auch noch mit zusätzlichen, speziell entwickelten Features erweitern, die sich von der Benutzeroberfläche bei ChatGPT Plus unterscheiden.

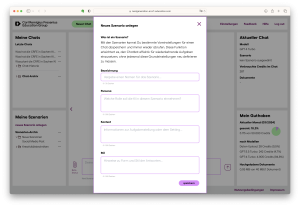

Das ist zum Beispiel eine Möglichkeit die Chats in einer Ordnerstruktur übersichtlicher abzulegen. Oder die Möglichkeit, sogenannte „Szenarien“ für wiederkehrende Aufgaben zu erstellen. Diese individuell anpassbaren Szenarien fördern nicht nur die Effizienz, sondern auch den kreativen Austausch über die Anwendungsmöglichkeiten der KI. Näheres dazu bei der Vorstellung im Video ab 7:20 Min. Diese Szenarien sind so etwas, wie eine vereinfachte Alternative zu den GPTs die man in ChatGPT Plus generieren kann. Denn diese Funktionalität wird bei der Nutzung über die API Schnittstelle bisher nicht angeboten.

Ausblick

Die erste Projektphase ist mit dem Launch der Plattform erfolgreich abgeschlossen. Der Beschluss zur Umsetzung ist übrigens erst in einer Vorstandssitzung Anfang dieses Jahres gefallen. Von der Unterzeichnung der Verträge mit der Firma scieneers bis zum Go Live der Plattform sind dann gerade einmal zwei Monate verstrichen. In der aktuellen zweiten Projektphase nach Einführung geht es darum eine Basiskompetenz bei möglichst vielen Mitarbeiter:innen und Studierenden zu erreichen. Dazu werden verschiedene Schulungs- und Weiterbildungsangebote in synchroner und asynchroner Form umgesetzt. In einer dritten Phase werden von April bis Juli viele kleine Workshops mit den verschiedenen Zielgruppen und Abteilungen im Unternehmen stattfinden, um zu identifizieren, was die individuellen Use-Cases mit dem höchsten Potenzial an Effizienz- oder Qualitätssteigerung in alltäglichen Arbeitsprozessen sind, uns was benötigt würde, um diese mit KI-Unterstützung umzusetzen. Diese Use Cases werden dann geclustert, bewertet, priorisiert und im Juli dem Vorstand präsentiert. In einer vierten Projektphase sollen dann in der zweiten Jahreshälfte möglichst viele der Use-Cases mit dem größten Potenzial als Pilotprojekte umgesetzt und evaluiert werden. Bei Erfolg sollen die dann skaliert und in den Regelbetrieb überführt werden.

Über den Autor

Prof. Uwe Stoklossa unterrichtet eigentlich Kommunikationsdesign und neue Medien im Fachbereich Design. In seiner Funktion als Projektleiter KI im Vizepräsidium für Campusstudium und Qualitätsentwicklung an der Hochschule Fresenius, geführt von Prof. Dr. Stephanie Heinecke, war er verantwortlich für die Umsetzung und die Einführung der unternehmensinternen Plattform „NextGeneration:AI“. Dies geschah in Zusammenarbeit mit einer interdisziplinären Arbeitsgruppe aus IT, Digitalem Competence-Center, Datenschutz- und Rechtsabteilung, Marketing, Hochschuldidaktik, Zentraler Contentproduktion und Unternehmenskommunikation.