Einsatz von KI-Textdetekoren in Lehre & Unterricht? Zu 100 % der falsche Weg!

Ein Beitrag von Matthias Kindt

Spätestens seitdem OpenAI mit dem KI-Sprachmodell ChatGPT-3.5 im November 2022 an den Start ging und wie ein Orkan durch so manche Bildungseinrichtung flog, stellen sich vor allem Lehrende die Frage, wie sie denn solche Texte auf Grundlage einer Künstlichen Intelligenz erkennen können. Sind zuverlässige Tools auf dem Markt, die KI-generierte Beiträge identifizieren und sich als Detektoren eignen?

- Arbeitsweise

- Rechtliche Grundlage

- Nutzung & Klassifizierung

- Internationale Studie

- Lehrkräfte als Detektive

- Fazit: Finger weg!

- Quellenangaben

- Studie PDF

KI-Detektoren auf der Grundlage von Wahrscheinlichkeiten

Die angeblichen Heilsbringer zum Erkennen KI-generierter Texte arbeiten auf der Basis von Wahrscheinlichkeiten und geben nach der Tool-Analyse einen Wert in Prozent oder einer Klassifizierung wie etwa “wahrscheinlich” aus. Die Anwendungen sollen Regelmäßigkeiten im Text etwa hinsichtlich der Anordnung von Wörtern identifizieren können, um die Arbeit eines KI-Sprachmodells nachzuweisen. Da es sich bei den Detektor-Tools i.d.R. nicht um Open-Source-basierte Programme hält, muss man als User der Vorgehensweise der Entwickler vertrauen und dementsprechend auch auf das ausgegebene Resultat. Einen Einblick in die exakte Vorgehensweise etwa über den Code gibt es dabei nicht.

Welche rechtliche Grundlage ist gegeben?

Falls KI-Detektortools zum Einsatz kommen, dann muss der Vorgang auch bis zum Ende gedacht werden und zwar im Worst-Case-Szenario, dass etwa ein Schüler oder Studierender auf der Basis der genutzten Anwendung zu einem bestimmten Prozentsatz als Schummler entlarvt wurde und somit Konsequenzen bzw. Sanktionen vorzunehmen sind. Doch falls der oder die Lernende die “Tat” nicht gesteht, lassen sich dann trotzdem die Sanktionsmaßnahmen durchsetzen und zwar nachhaltig, also im schlimmsten Fall sogar vor Gericht? Nehmen Anwälte vor Gericht solche Erkennungsprogramme von KI-basierten Texten im Handumdrehen auseinander oder haben die Ergebnisse auch final Bestand? Dies ist schon der Extremfall, aber leider muss man den Einsatz der Tools auch komplett bis zum Ende denken, sonst ist es eine Frage der Zeit, bis den Lehrenden & Bildungseinrichtungen die ganze Thematik ganz schwer um die Ohren fliegt.

Generell ist die rechtliche Grundlage bezüglich des Einsatzes von Anwendungen auf Basis von Künstlicher Intelligenzen in Deutschland und auch in der Europäischen Union noch mehr als wacklig bzw. befindet sich häufig in Grauzonen. Es wird dementsprechend von entscheidender Bedeutung sein, dass sich der oder die Schummler schuldig bekennen und somit ihr Vergehen eingestehen. Von daher ist die Wahrscheinlichkeit recht hoch, dass diese Software so eingesetzt wird, um die betreffenden Personen maximal unter Druck zu setzen und so ein Geständnis zu erzwingen. Also in die Richtung „ich hab deinen Text 3 Mal gecheckt und es ist eindeutig, dass du eine KI verwendet hast. Gib es zu!” Aber ein findiger Schüler wird dann wohl die Gegenfrage stellen: „Die Wahrscheinlichkeit liegt nicht bei 100 % und wie sieht es eigentlich mit der Fehlerquote solcher Tools aus?”

An diesem simplen Sachverhalt erkennt man schon die Problematik, die sich so einfach nicht lösen lässt. Aber welche Software darf ich überhaupt einsetzen? Es gibt ja mittlerweile eine schier unglaubliche Auswahl an Detektoren, ob von OpenAI himself mit dem Text Classifier, der übrigens erst ab einer Texteingabe von 1000 Wörtern funktioniert oder weiteren Anbietern wie DetectGPT, das von einem Forschungsteam der Stanford University entwickelt wurde und eine Erkennungsquote von 95 % verspricht. Auch eine auf das Bildungssystem spezialisierte Anwendung ist mit GPTZeroX am Start, die nun also die Zauberformel für alle Pädagogen gefunden haben soll und fortan allen Schummlern das Fürchten lehrt.

In initial experiments, the tool DetectGPT accurately identifies authorship 95% of the time across five popular open-source LLMs. Quelle: Stanford University

Dürfen Lehrende sich selber eine “bunte Tool-Tüte” zusammenstellen oder muss etwa das Kultusministerium diesbezüglich klare Vorgaben mittels einer veröffentlichten Linkliste auf ihrer eigenen Homepage machen? Dürfen hervorragende Anwendungen Made in USA zum Einsatz kommen oder widerspricht dies dem DSGVO, wodurch etwa Lehrkräfte auf Programme Made in EU zurückgreifen müssen, die aber schlechtere Ergebnisse erzielen und somit mehr Lernende zu unrecht beschuldigen? Muss dann mehrfach gecheckt/geklickt werden, um final Sanktionen zu erheben? Dürfen nur ausgewählte Sprachmodelle genutzt werden, bei denen die verfügbaren “Erkenner” greifen? Also brandneue KI-Chatbots sind erst einmal verboten, da die passenden Detektiv-Tools noch nicht auf dem Markt sind? Wir sehen an dieser Stelle schon, dass immer mehr (rechtliche) Fragen auftauchen, die kaum zu beantworten sind und allen Bildungsbeteiligten langfristig allerlei argumentativen Spielraum bieten.

Nutzung & Klassifizierung

Im unteren Kurzvideo wird die Funktionsweise vom OpenAI Text Classifier gezeigt, der in diesem Beispiel einfach das Resultat likely, also wahrscheinlich im Kontext der eigenen Klassifizierung ausgibt.

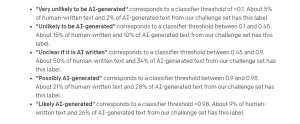

Die Nutzung der Detektoren ist mehr als einfach. Den Text per Copy & Paste in die Erkennungsmaschine eingeben und den farbigen Button betätigen. In Kürze wird ein Resultat präsentiert. Es kommt durchaus vor, dass bei mehrmaligem Wiederholen des Vorgangs unterschiedliche Ergebnisse angezeigt werden. Dann ist die Verwirrung definitiv perfekt. Der untere Screenshot zeigt die Klassifizierung seitens OpenAI und gibt zu den jeweiligen Kategorien auch eigene Werte an, die auf der Grundlage ihrer “Challenge” basieren. In diesem Fall wurden 5 Kategorien gewählt. Dies ist von Tool zu Tool verschieden. Da gibt es keine einheitliche Einordnung.

Laut den Angaben von OpenAI, werden 9 % der von Menschen geschriebenen Texte als KI-generierte Beiträge erfasst, die das Label “likely/wahrscheinlich” tragen, wie dies bei unserem Beispielbeitrag der Fall ist. Folgende Annahme: 100 Studierendenarbeiten werden kontrolliert und alle wurden eigenständig von Menschenhand verfasst. Trotzdem schlägt dann das Tool im Durchschnitt bei 9 Studentinnen & Studenten Alarm, die nun mindestens in Teilen verdächtigt werden eine Künstlcihe Intelligenz für ihre wissenschaftlichen Arbeiten genutzt zu haben und das fälschlicherweise. Also funktioniert der KI-Detektor im Umkehrschluss zu maximal 91 %. Werte darunter sind wohl weitaus wahrscheinlicher, da Unternehmen sich zu gerne mit Maximalwerte unter aller besten Bedingungen rühmen. Siehe hierbei Dieselabgaswerte von Volkswagen & Co 😉“Wahrscheinlich KI-generiert” entspricht einem Klassifikator-Schwellenwert >0,98. Ungefähr 9 Prozent des von Menschen geschriebenen Textes und 26 Prozent des von KI generierten Textes in unserem Challenge Set haben dieses Label.

Aufschlussreiche Studie zur Effizienz von KI-Detektoren: Komplett unbrauchbar!

Um die Zuverlässigkeit von Detection-Tools zu untersuchen, haben unter andrem Prof. Dr. Debora Weber-Wulff von der HTW Berlin und internationale Kollegen eine umfangreiche Studie veröffentlicht, die zu eindeutigen Ergebnissen kommt.

Ob ein Text mit einer generativen KI erstellt wurde oder nicht, lässt sich nicht eindeutig bestimmen. Das zeigt eine empirische Studie von Debora Weber-Wulff (HTW Berlin) und ihrem Team. Quelle: Prof. Dr. Johannes Moskaliuk

Ein Blogbeitrag von Prof. Dr. Johannes Moskaliuk von der International School of Management hat diese Studie gut zusammengefasst, die insgesamt 14 Anwendungen wie unter anderem Turnitin und PlagiarismCheck.org analysiert hat und zum Schluss kommt, dass solche Tools aktuell unbrauchbar sind, da die Erkennungsquote viel zu gering ist.

Bei Texten, die von einer KI erstellt wurden, und anschließend überarbeitet wurden, liegt die Genauigkeit nur bei 50 %. Vorsicht formuliert bedeutet das: Ein von einer KI-erstellter Text, der von einem Menschen leicht überarbeitet wurde, nicht mehr zuverlässig erkannt. Quelle: Prof. Dr. Johannes Moskaliuk

So gut wie jeder hat wahrscheinlich eine eigene Meinung zu KI-Detektoren, ob diese nun eingesetzt werden sollten oder eben nicht, aber die besten Argumente liefern wohl Studien, also wissenschaftliche Ergebnisse, die vom Fachperson etwa in Form von Professoren und Doktoranden durchgeführt wurden. Hier spielen Emotionen und ganz allgemein persönliche Belange i.d.R. überhaupt keine Rolle. Entscheidend sind (ehrliche) Statistiken, auf dieser Grundlage diese Programme zu beurteilen sind. Die Resultate im Rahmen dieser internationalen Untersuchungen sind mehr als eindeutig!

Lehrkräfte als Detektive? Eine nachhaltige Beschädigung des Lehrberufs!

Insbesondere der Beruf der Lehrkraft steht schon seit einiger Zeit aus diversen Gründen unter Starkstrom, um dies an dieser Stelle ganz vorsichtig zu formulieren. Nun sollen sich Lehrerinnen & Lehrer also auch noch verstärkt als Detektive betätigen, mit Wahrscheinlichkeiten hantieren und schlussendlich unvermeidlich fälschlicherweise Beschuldigungen gegen Schülerinnen & Schüler aussprechen? Müssen dafür dann extra Zeitkontingente eingeplant werden? Also z.B. bei einer Klasse von 25 Schülern muss eine Hausarbeit nun je nach Tool etwa 3 Mal gecheckt werden, um daraus dann den Durchschnitt zu ziehen? Gibt es dann dafür extra (Online-)Fortbildungen, die auch bezahlt werden? Was machen solche Prüftools eigentlich mit dem Vertrauensverhältnis zwischen Lehrenden & Lernenden und auch mit Blick auf das Lernklima insgesamt? Wird irgendwann auch der ehrlichste Schüler verdächtigt, ein Betrüger zu sein, weil diese Erkennungssoftware niemals zu 100 % funktionieren werden? Und müssen Pädagogen den Plagiatscheck per Screencast/Kurz-Video als Beweis aufzeichnen, damit dieser bei einer rechtlichen Auseinandersetzung als Beweismittel im Worst-Case-Szenario wie dem verpflichtenden Schulabgang Bestand hat? Wer macht dann die Vorgaben zu diesen Aufzeichnungen oder darf dies jeder anders händeln? Da tauchen wirklich sehr viele Fragen auf, die den Lehrberuf noch weiter beschädigen, bis auch wirklich die allerletzte potenzielle Lehrkraft dann doch lieber BWL, Germanistik oder doch eben Pflanzenkunde studiert.

Fazit: Finger weg von solchen “Tools”

Ein Verbot von KI-Detektoren durch die Kultusministerien & Hochschulen wäre mehr als angebracht, da diese Anwendungen selbst unter den allerbesten Bedingungen auch für gut ausgebildete Pädagogen nicht einwandfrei händelbar sind. Generell bin ich gegen solche Verbote, da es in der Regel einen eleganteren Weg gibt Probleme zu lösen, aber falls etwa bei einem VW Golf dauerhaft die Blinker vorne rechts und hinten links nicht funktionieren und ab und an mal die Bremsen blockieren, dann ist dieses Auto definitiv nicht straßenverkehrstauglich und muss dementsprechend auch runter von unseren Straßen, da es sonst langfristig zu einer Gefahr für alle Beteiligten wird.

Aus meiner Sicht haben die Anbieter solche KI-Sprachmodelle wie OpenAI (ChatGPT), Google (Bard) & Co überhaupt kein Interesse daran, dass ein Tool all ihre KI-generierten Texte erkennen kann. Ganz im Gegenteil, da dies zu einem echten Wettbewerbsnachteil werden könnte, da womöglich die Nutzer plötzlich zu anderen Anwendungen wechseln, die man unbehelligt verwenden kann, ohne dass einem Lehrer und Dozierende auf die Schliche kommen. Angenommen ein KI-Detektor schafft es wirklich an die 99 % aller Texte von etwa ChatGPT zu entlarven. Ist es dann nicht recht wahrscheinlich, dass OpenAI & Co den Code des Sprachmodells anpassen/updaten und schon kommt die Software nur noch auf 83 %? Wäre nicht sonst auch das Geschäftsmodell der Firmen in Gefahr?

Zudem zeigen die Untersuchungen, der in diesem Blogbeitrag angeführten Studie von Prof. Dr. Debora Weber-Wulff ganz eindeutige wissenschaftliche Ergebnisse, die den sinnvollen Einsatz von Erkennungstools in diesem Zustand vor allem im Bildungssektor unmöglich machen.

Bei den Lehrenden werden zusätzlich in regelmäßigen Abständen unnötig Erwartungen geweckt, die einfach nicht erfüllbar sind. Nun ist also wieder ein neues Tool auf dem Markt, dass verspricht jeden Text auf der Basis von Künstlichen Intelligenzen zu erkennen und dann wieder und wieder. Unsere Medien publizieren nur zu gerne Artikel, die viele Klicks bei den Lesern generieren und das Thema von KI-Detektoren ist genau solch eines, da es die Gemüter erhitzt und Diskussionen anregt. Also werden “Journalisten” weiterhin verstärkt Beiträge zu diesen angeblichen Heilsbringern veröffentlichen, um möglichst hohe Reichweiten zu erzielen. Ob dies im Anschluss Unsicherheiten bei den Bildungsbeteiligten verursacht, ist dabei sekundär bzw. wirklich völlig egal! Hierbei hilf nur: Ignorieren! Diese Artikel erst gar nicht lesen, ganz egal wie knackig die Headlines bzgl. krasser Keywords (Clickbaiting) sind. Insbesondere Lehrende müssen im Vorfeld eine eindeutige Meinung zu diesen KI-Tools haben, um sich nicht ebenfalls inmitten eines aufgeschreckten Hühnerhaufens wiederzufinden, der ab einem bestimmten Zeitpunkt auch nicht mehr rational denken kann, weil nun die Emotionen übernehmen!

Im Zuge der KI-Sprachmodelle hat sich ein neuer Markt der Erkennungssoftware parallel mitentwickelt, in dem die Akteure zum Teil ordentlich Geld über ein Abonnement verdienen. Es gibt verschiedene Kanäle etwa via Social Media oder üblichen Medien kundzutun und dies wird wohl auch so bleiben. Lasst euch davon nicht beeinflussen, sondern überlegt immer direkt selbstständig, ob dies denn von der Wahrscheinlichkeit her überhaupt sein kann. Der gesunde Menschenverstand weist einem in der Regel den richtigen Weg.

Als finales Argument gegen KI-Textdetektoren wird die Möglichkeit herangeführt, KI-Chatbots so zu trainieren, um einen bestimmten Stil zu imitieren. Falls es Schülern oder Studierenden gelingt via Uplaod von eigenen Aufsätzen ChatGPT & Co per Finetuning etwa hinsichtlich Satzbau, Wortfolge… so einzustellen, dass die KIs fortan den eigenen Stil perfekt wiedergeben, dann müssten solche Erkennungstools komplett wertlos sein. Andere Lernenden, die technisch nicht so gut unterwegs sind, wären dann stark benachteiligt. Es wird sicherlich immer eine Variante geben, Detektoren zu umgehen, auch mit Blick auf die zahlreichen kostenfreien KI-Skripte auf GitHub, die täglich immer mehr werden. Müssen Lehrende diese Erweiterungen dann auch noch kontrollieren bzw. stets im Auge haben? NEXT??

Quelle:

Studie: Testing of Detection Tools for AI-Generated Text – Autoren: Debora Weber-Wulff (University of Applied Sciences HTW Berlin, Germany), Alla Anohina-Naumeca (Riga Technical University, Latvia), Sonja Bjelobaba (Uppsala University, Sweden), Tomáš Foltýnek (Masaryk University, Czechia), Jean Guerrero-Dib (Universidad de Monterrey, Mexico), Olumide Popoola (Queen Mary University of London, UK), Petr Šigut (Masaryk University, Czechia), Lorna Waddington (University of Leeds, UK)

Moskaliuk.com – Homepage von Prof. Dr. Johannes Moskaliuk: Zum Blogbeitrag (2023)

Stanford University – Human Writer or AI? Scholars Build a Detection Tool: Zum Beitrag (2023)

The-decoder.de – Stanford DetectGPT und GPTZeroX: Neue Tools für KI-Text-Erkennung: Zum Beitrag (2023)

Studie zu Detection-Tools

Autor